Combustion Line Extreme Abnormal Flame Image Adversarial Generation for Municipal Solid Waste Incineration Processes

-

摘要: 燃烧线是表征城市固废焚烧(municipal solid waste incineration,MSWI)过程燃烧稳定性的关键参数之一。完备的火焰图像模板库是实现燃烧线量化以从检测视角代替依靠运行专家“人工看火”,进而通过实时反馈提升MSWI过程控制的智能化水平的基础。针对燃烧线极端异常火焰图像缺失问题,该文提出基于机理知识和对抗网络的燃烧线极端异常火焰图像生成方法。首先,基于焚烧炉内三维空间位置到图像像素点的机理映射关系分析燃烧线极端异常火焰图像,通过对正常火焰图像像素点的平移、拼接和组合等方式获取伪标记的燃烧线极端异常火焰图像;然后,采用循环生成对抗网络(cycle generative adversarial networks,CycleGAN)获得符合真实火焰图像分布的候选图像;最后,提出组合基于弗雷歇距离(Fréchet inception distance,FID)评估最优模型参数和根据伪标记筛选最终燃烧线极端异常火焰图像的2级评估与筛选策略。针对北京某MSWI厂的实验结果表明:依据燃烧线可划分图像为51%~73.6%正常、47%~51%和73.6%~100%异常、0%~47%极端异常;当第2级评估阈值设定为0.4时,所提方法生成合格极端异常火焰图像的比例为85.7%,优于传统评估方法。

-

关键词:

- 城市固废焚烧 /

- 燃烧线量化 /

- 燃烧线极端异常火焰图像 /

- 循环生成对抗网络 /

- 图像评估与选择

Abstract: Combustion line is one of the key parameters to represent the combustion stability of municipal solid waste incineration (MSWI) processes. A complete flame image template library is the foundation for achieving combustion line quantification from a detection perspective instead of relying on operational experts to manually observe the flame, and improving the intelligence level of MSWI process control through real-time feedback. Aiming at the problem of missing combustion line flame image under extreme combustion state, a generation method based on fusion of mechanism knowledge and adversarial technology is proposed. First, based on the mechanism mapping relationship between the three- dimensional spatial position in the incinerator and the image pixels, the extreme abnormal flame samples are analyzed. The pseudo-label samples are obtained by shifting, stitching and combining the pixel points of normal sample. Then, the candidate extreme abnormal flames are obtained by using cycle generative adversarial networks (CycleGAN). Finally, a new two-level evaluation strategy is designed by combing the optimal model parameters evaluation based on Fréchet Inception Distance (FID) and the final extreme abnormal flame image selection according to the pseudo label. The experimental results based on a MSWI plant of Beijing show that the combustion line can be categorized into three ranges: 51% to 73.6% as normal, 47% to 51% and 73.6% to 100% as abnormal, and 0% to 47% as extreme abnormal.. When the second level evaluation threshold is set to 0.4, the proportion of the satisfied extreme abnormal flame image generated by the proposed method is 85.7%, which is better than the traditional evaluation method. -

0. 引言

城市固废(municipal solid waste,MSW)受居民生活习惯、季节气候、分类程度等因素的影响,具有杂质多、含水率高、热值波动大等特点[1]。城市固废焚烧(MSW incineration,MSWI)作为一种世界范围内广泛采用的MSW典型处理方式,具有无害化、减量化和资源化等优势[2-3]。目前,发展中国家的MSWI技术仍存在诸多问题,其中最为突出的是因人工经验操作模式的随意性和精力的有限性导致燃烧状态不稳定,进而造成污染物排放波动大[4~6]。此外,燃烧状态的不稳定也易造成炉膛内的结焦、积灰和腐蚀等问题,严重时甚至会引起炉膛爆炸等安全问题[7]。因此,维持稳定的燃烧状态是保障MSWI过程运行高效和排放达标的关键之一。

实现MSWI过程的稳定燃烧需根据被控量变化趋势及时调整操纵变量。国外先进燃烧控制系统所涉及的主要被控量包括:炉膛温度、烟气含氧量、蒸汽流量和燃烧线[8-9]。燃烧线指MSW燃烧结束变为灰烬的位置[10],其能够反映当前MSW在炉排上的燃烧状况。以北京某MSWI厂为例,通常MSWI过程的火焰图像依据燃烧线的位置分为正常(燃烧发生在燃烧炉排)、异常(燃烧发生在干燥炉排中部和后端以及燃烬炉排)和极端异常(燃烧发生在干燥炉排前端)3种类别。目前,国内并未实现燃烧线的智能感知与检测[11]。运行专家常通过观察火焰视频凭经验识别燃烧线位置[12],进而修正“布风布料”策略以保证系统的稳定运行。但上述方法存在主观性与随意性,若能通过构建火焰图像驱动的燃烧线量化系统,将能够辅助MSWI过程的稳定控制,进而避免因排放超标被罚款而造成的经济损失。实现上述目标需要燃烧线正常、异常和极端异常的全局分布数据集。针对燃烧线数据集存在的标记成本高、分布不均等问题,郭等提出燃烧线异常火焰图像的生成方法[13],但并未解决燃烧线极端异常火焰图像的缺失问题。如何获取上述缺失火焰图像是搭建燃烧线量化系统需解决的开放性问题之一。

图像增强方法(几何变换、颜色抖动、随机噪声等)[14]仅是对原始数据进行非生成式变换,并未增加高级语义特征信息[15],不能用于生成燃烧线极端异常火焰图像。生成式对抗网络(generative adversarial network,GAN)“创造”的图像能够有效地解决特殊样本稀缺的问题[16-17]。Yang等针对焊接自动检测过程中的异常数据稀缺问题,提出基于GAN的数据增强算法[18];Lian等针对自动表面缺陷检测研究中的数据稀缺问题,利用GAN生成非常规缺陷图像以扩充样本集[19];Niu等针对工业站点缺陷图像不足和标记成本高的问题,提出一种生成缺陷图像的方法[20];Wu等提出ResMaskGAN用以解决表面缺陷自动检测异常数据集稀少的问题[21];郭等提出混合GAN和非生成式数据增强用于解决MSWI过程燃烧线异常火焰图像稀少的问题[13]。上述基于GAN的数据增强策略最终将达到纳什均衡状态[22],生成器能够生成符合小样本概率分布的图像。但是,MSWI过程的燃烧线极端异常火焰图像仅在启停炉、操作不当或故障等工况下存在,采用上述生成方法难以获取本文所需的火焰图像的特征信息。

针对MSWI过程而言,燃烧发生在焚烧炉内的有限空间内,并且拍摄图像的摄像机位置固定,因此理论上能够通过“剪切与拼凑”方式得到燃烧线处于任何位置的伪标记火焰图像。但这些图像并不符合真实火焰图像的概率分布,需要进行“转换”处理以增强其真实性。通常,图像到图像的转换被定义为将一个场景的表示转换成另外一个场景[23],其可解决纹理合成、图像超分辨率重建、图像分割、风格转换和数据增强等诸多问题,例如自动驾驶领域针对获得大量配对数据的成本昂贵的问题,通过图像到图像的转换方法合成各种街景图片以丰富场景数据集[24-25]。此外,图像到图像的转换也用于生成工业表面缺陷数据[26-27]。理论上,基于循环一致性理念的生成对抗网络(cycle-consistent adversarial networks,CycleGAN)[28]能够在无匹配数据的情况下实现图像到图像的转换。因此,如何结合CycleGAN实现伪标记燃烧线极端异常火焰图像朝向“真实性”进行转换是有待解决的问题之一。

此外,针对生成图像的评估和选择,Miyato等提出GAN-train方法[29],通过对比基于cifar100数据集和基于合成图像训练的CNN分类器性能评估生成图像质量。进一步,Shmelkov等提出同时进行GAN-train和GAN-test的评估方法[30],具体为:GAN-train在生成的图像上训练分类器,并测量其在真实测试图像上的性能,进而对生成图像的多样性和真实感进行评价;GAN-test在真实图像上训练分类器并在生成图像上评估,进而衡量图像的真实感。传统生成图像的评估策略是先提取真实图像集和生成图像集的特征,再度量特征向量之间的距离。Borji等综述了24个定量和5个定性的生成图像的评价指标[31],其中初始得分(inception score,IS)[32]和Fréchet inception distance(FID)[33-34]是常用的生成图像质量评估指标。然而,由于本文所生成图像的部分特征是基于知识获取,并不在真实图像存在,使得上述方法并不完全适用。如何结合MSWI过程特点对生成的燃烧线极端异常火焰图像进行评估与筛选也是待解决的问题。

因此,针对MSWI过程燃烧线极端异常火焰图像缺失的问题,本文提出融合机理知识和对抗网络的图像生成方法,主要工作如下:1)基于焚烧炉内三维空间的物理位置和成像原理等机理知识对炉膛内的理论燃烧位置进行精准标定,进而获取燃烧线极端异常的伪标记图像集;2)采用CycleGAN将伪标记图像集转换为候选燃烧线极端异常火焰图像;3)针对上述候选图像,提出一种2级图像评估与选择方法,可获得最终合格的火焰图像。

1. 生成策略与算法

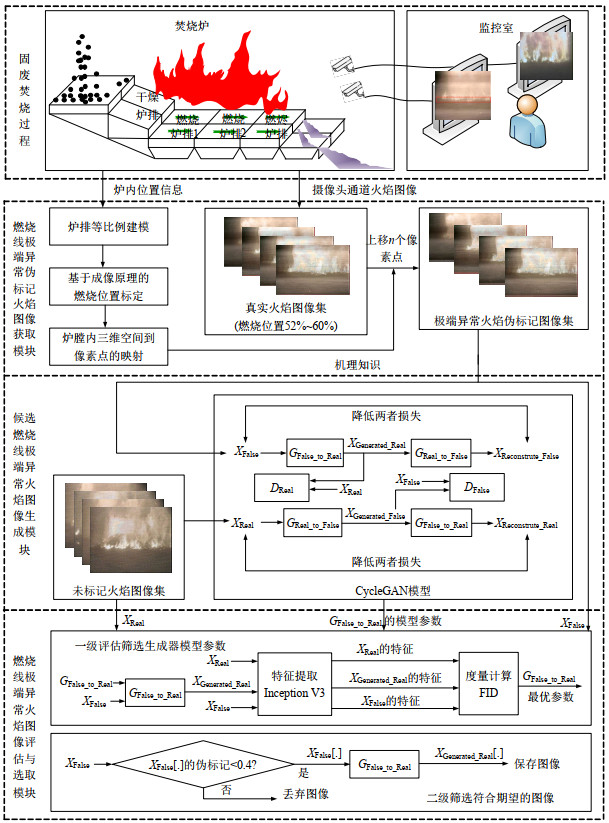

本文提出如图 1所示的融合机理知识和GAN的MSWI过程燃烧线极端异常火焰图像生成策略,包括:燃烧线极端异常伪标记火焰图像获取模块、候选燃烧线极端异常火焰图像生成模块和燃烧线极端异常火焰图像评估与选取模块。

图 1中:GReal_to_False和DFalse_to_Real和为2个生成器;DReal和DFalse为2个判别器;XReal为真实图像集;XFalse为燃烧线极端异常伪标记火焰图像集;XGenerated_False和XGenerated_Real为生成的火焰图像集;XReconstrute_False和XReconstrute_Real为重构的火焰图像集;XFalse[⋅]表示某张燃烧线极端异常伪标记火焰图像。

1.1 燃烧线极端异常伪标记火焰图像获取模块

通过对炉排的等比例建模、基于成像原理的燃烧位置标定和炉膛内三维空间坐标到像素点的映射进行知识获取,通过对像素点的精准平移、拼接和组合等方式获取燃烧线极端异常伪标记火焰图像。

燃烧线的标定和构建相关数据集是该模块的必要前提之一。本文采用包括二值化处理、中值滤波、膨胀处理和边缘计算等步骤的形态学处理,以及基于图像中部分区域边缘位置纵坐标均值和方差的燃烧线位置标定算法确定燃烧线。

1.1.1 炉排等比例建模子模块

依据已知的炉排长度和摄像头位置计算炉排与摄像头之间的位置信息,如图 2所示。图 2中的虚线为辅助线,点A—L和Z等为重要节点标记;lAB、lBC、lCD、lDE、lEF、lBF、lFG、lHG、lHI、lAK和lHJ分别为对应线段的长度,即各炉排与台阶长度以及摄像头位置信息等;对包含炉排与摄像头的位置信息的▲AED、▲AGF、▲JHA、▲AFE和▲AHG中,依据余弦定理和勾股定理可依次求解得到各边长度。

1.1.2 基于成像原理的燃烧位置标定子模块

在获取炉膛内部位置信息后,需求解这些位置在火焰图像上的位置。成像原理同理于“小孔成像”,如图 2所示。图 2中:lMN、lNO、lOP、lPQ和lQR分别表示燃烬炉排、燃烬炉排与燃烧炉排台阶、燃烧炉排、燃烧炉排与干燥炉排台阶和干燥炉排的成像长度;DW垂直于DE,分别交AE、AF、AG、AH和AJ于S、T、U、V和W,lDS、lST、lTU、lUV和lVW表示对应线段的长度。

标定过程为:首先,针对▲DAS、▲SAT、▲TAU、▲UAV和▲VAW,根据余弦定理求解lDS、lST、lTU、lUV和lVW;然后,由相似三角形可得lMN:lNO :lOP :lPQ:lQR =lDS:lST:lTU:lUV :lVW。

1.1.3 三维空间位置到像素点的映射

以北京某MSWI发电厂为例,其摄像头视频通道分辨率为720×576;干燥炉排未能在摄像头中完全成像。采用如下步骤实现三维空间到像素点映射关系的计算:1)设图 3中区域1—8分别在图像中占n1—n8个像素点,经过度量可得n6:8∑i=1ni的值。由于8∑i=1ni已知,可求得n6值,即线段PO对应的燃烧炉排所映射的像素点;2)进一步,由lRQ: lRP: lQP: lPO: lON: lNM可求得炉内实际位置所对应的像素点。最终,三维空间位置到图像像素点映射关系的计算结果如表 1所示。考虑到料层厚度的影响,干燥段和燃烧段前端的成像比例需修正5%。

表 1 三维空间位置到图像像素点的映射关系Table 1. Mapping relationships from three-dimensional space location to image pixel points炉膛内实际位置 成像的像

素点范围在图像中的

比例范围/%炉排

长度/mm燃烧线在图像中的

比例范围/%燃烧线状态 炉膛前拱、进料口、进料段与干燥炉排台阶 0~301 0~52.4 — 0~47 极端异常 炉排 干燥炉排 302~320 52.4~55.7 2840 47~51 异常 干燥炉排与燃烧炉排台阶 321~350 55.7~60.9 679.78 51~60.9 正常 燃烧炉排 351~423 60.9~73.6 5680 60.9~73.6 正常 燃烧炉排与燃烬炉排台阶 424~484 73.6~84.0 532.09 73.6~84.0 异常 部分燃烬炉排 484~575 84.0~100 — 84.0~100 异常 1.1.4 伪标记图像获取

燃烧线期望状态为MSW在燃烧炉排上燃烧,对应的燃烧线位置约在51%~73.6%。燃烧线极端异常状态为MSW在干燥炉排前端燃烧,相应的燃烧线位置上限约为47%。针对燃烧线极端异常状态,本文采用对像素点进行“平移+拼接”的方式实现伪标记火焰图像的获取,并记录对应燃烧线的伪标记值。

设摄像头采集图像的像素为nhigh*nwide,将选取的MSW燃烧位置清晰的真实图像记为X′,“平移+拼接”获取的伪标记图像集记为XFalse,其由X′上移n个像素点而得,如下所示:

Xfalse=X′[:,n:,:,:]+X′[:,nwide−n:,:,:] (1) 式中n的取值范围为20~40个像素点。

1.2 候选燃烧线极端异常火焰图像生成模块

CycleGAN能够采用无标签方式实现图像到图像的转换,其将含燃烧线极端异常火焰位置信息的伪标记图像转换成候选燃烧线极端异常火焰图像。CycleGAN由生成和判别网络各2个组成,其结构如表 2所示。

表 2 生成和判别网络结构Table 2. Structure of generation and discrimination network生成网络 判别网络 下

采

样

模

块x=ZeroPadding2D((3, 3))(input) Conv2D(64, (3, 3)) x=Conv2D(64, (7, 7))(x) LeakyReLU((alpha=0.2)) x=InstanceNormalization()(x) Conv2D(128, (4, 4), strides=1) x=Activation(‘relu’)(x) InstanceNormalization() x=ZeroPadding2D((1, 1))(x) LeakyReLU((alpha=0.2)) x=Conv2D(128, (3, 3))(x) Conv2D(256, (4, 4), strides=1) x=InstanceNormalization()(x) InstanceNormalization() x=Activation(‘relu’)(x) LeakyReLU((alpha=0.2)) x=ZeroPadding2D((1, 1))(x) Conv2D(512, (4, 4), strides=1) x=Conv2D(64, (3, 3))(x) InstanceNormalization() x=InstanceNormalization()(x) LeakyReLU((alpha=0.2)) x=Activation(‘relu’)(x) Conv2D(1, (3, 3), strides=1) 残

差

块X1=ZeroPadding2D((3, 3))(x) x=Conv2D(256, (3, 3))(X1) x=InstanceNormalization()(x) x=Activation(‘relu’)(x) x=ZeroPadding2D((3, 3))(x) x=Conv2D(256, (3, 3))(x) x=InstanceNormalization()(x) x=layers.add([x, X1]) x=Activation(‘relu’)(x) ……(残差块*8) 上

采

样

模

块x=UpSampling((2, 2))(x) x=ZeroPadding2D((1, 1))(x) x=Conv2D(128, (3, 3))(x) x=InstanceNormalization()(x) x=Activation(‘relu’)(x) x=UpSampling2D((2, 2)(x)) x=ZeroPadding2D((1, 1))(x) x=Conv2D(128, (3, 3))(x) x=InstanceNormalization()(x) x=Activation(‘relu’)(x) x=ZeroPadding2D((3, 3))(x) x=Conv2D(3, (7, 7))(x) x=InstanceNormalization()(x) x=Activation(‘tanh’)(x) 生成网络主要分为下采样、残差和上采样模块,其中:下采样模块由零填充(ZeroPadding2D)、卷积(Conv2D)、实例归一化(InstanceNormalization)层和Relu激活函数的3次堆叠组成,实现火焰图像的特征提取;残差模块的组成与下采样模块相同,输入数据可直接传递给输出层以保证梯度不会消失,同时实现部分特征信息的自适应修正;上采样模块由上采样、零填充、卷积、实例归一化层和Relu激活函数的2次堆叠组成,采用零填充、卷积、实例归一化和Tanh激活函数生成最终图像。

判别网络由卷积层、LeakyRelu激活函数和实例归一化层组成,其过程为:通过卷积层叠加实现特征提取;通过在卷积层中间添加LeakyRelu函数,在增加网络非线性的同时保证判别网络与生成网络在博弈中的稳定性;通过实例归一化层单独计算每张图像像素的均值和方差,相对于批归一化层可避免图像与图像间的相互影响;最后,针对卷积层的输出判断每个像素点为真的概率。

候选燃烧线极端异常火焰图像生成模块通过生成网络与判别网络的博弈进行参数更新。

首先,直接获取XReal和XFalse,间接获取XGenerated_False、XGenerated_Real、XReconstrute_Real和XReconstrute_ False以及身份验证图像XReal_id和XFalse_id,判别网络结果YGenerated_False、YFalse、YReconstrute_Real和YReal。接着,更新生成网络,如下所示:

min (2) 式中:LG和θG为包括2个生成网络的生成器损失函数和网络参数;θGFalse_to_Real和θGReal_to_False为GReal_to_False和GFalse_to_ Real的网络参数;L1、L2、L3、L4、L5和L6均为损失函数,其定义如下:

{L_1} = \frac{1}{m}\sum\limits_{i = 1}^m {{{({Y_{{\text{Generated_Real}}}}[i] - {{\widehat Y}_{\text{1}}}[i])}^2}} (3) {L_2} = \frac{1}{k}\sum\limits_{i = 1}^k {{{({Y_{{\text{Generated_False}}}}[i] - {{\widehat Y}_{\text{1}}}[i])}^2}} (4) {L_3} = \frac{1}{k}\sum\limits_{i = 1}^k {|{X_{{\text{Reconstrute_Real}}}}[i] - {X_{{\text{Real}}}}[i]|} (5) {L_4} = \frac{1}{m}\sum\limits_{i = 1}^m {|{X_{{\text{Reconstrute_False}}}}[i] - {X_{{\text{False}}}}[i]|} (6) {L_5} = \frac{1}{k}\sum\limits_{i = 1}^k {|{X_{{\text{Real_id}}}}[i] - {X_{{\text{Real}}}}[i]|} (7) {L_6} = \frac{1}{m}\sum\limits_{i = 1}^m {|{X_{{\text{False_id}}}}[i] - {X_{{\text{False}}}}[i]|} (8) 式中:m和k为XFalse和XReal中图像的数量;L1和L2为普通GAN的损失,用于使生成图像更加逼真;L3和L4为循环一致损失,用于保证XGenerated_Real和XFalse以及XReal和XGenerated_False间的关联性;L5和L6为Identity损失,用于保证GFalse_to_ Real(XReal)生成的是真实数据集的图像和GReal_to_False (XFalse)生成的是伪标记数据集的图像。

然后,更新2个判别网络,如下所示:

\begin{gathered} \mathop {\min }\limits_{{\theta _{{D_{{\text{Real}}}}}}} {L_{{D_{{\text{Real}}}}}} = \mathop {\min }\limits_{{\theta _{{D_{{\text{Real}}}}}}} (0.5*\frac{1}{m}\sum\limits_{i = 1}^m {({Y_{{\text{Generated_Real}}}}[i]} - \hfill \\ \begin{array}{*{20}{c}} {}&{}&{}&{{{\widehat Y}_0}[i]{)^2}} \end{array} + 0.5*\frac{1}{k}\sum\limits_{i = 1}^k {{{({Y_{{\text{Real}}}}[i] - {{\widehat Y}_1}[i])}^2}} ) \hfill \\ \end{gathered} (9) \begin{gathered} \mathop {\min }\limits_{{\theta _{{D_{{\text{False}}}}}}} {L_{{D_{{\text{False}}}}}} = \mathop {\min }\limits_{{\theta _{{D_{{\text{False}}}}}}} (0.5*\frac{1}{k}\sum\limits_{i = 1}^k {({Y_{{\text{Generated_False}}}}[i]} - \hfill \\ \begin{array}{*{20}{c}} {}&{}&{}&{{{\widehat Y}_0}[i]{)^2}} \end{array} + 0.5*\frac{1}{m}\sum\limits_{i = 1}^m {{{({Y_{{\text{False}}}}[i] - {{\widehat Y}_1}[i])}^2}} \hfill \\ \end{gathered} (10) 最后,重复上述步骤。

在每轮循环结束时,保存网络参数和生成的候选燃烧线极端异常火焰图像。

1.3 燃烧线极端异常火焰图像评估与选取模块

理论上,期望生成的燃烧线极端异常火焰图像既要符合真实图像分布,又要保留伪标记图像的燃烧线位置信息。针对传统评估方法,若要同时满足上述要求是矛盾的,故本文提出针对燃烧线极端异常图像的2级评估方法,其中:第1级评估筛选生成器模型参数;第2级评估筛选候选数据集中符合燃烧线极端异常的火焰图像。上述评估中采用的FID函数以真实图像集Xr、生成图像集Xg和特征提取器为输入,获得该函数值的过程为:

首先,加载特征提取器提取2个图像集的特征矩阵Zr与Zg,如下:

{{\boldsymbol{Z}}_{\text{r}}} = \left[ {\begin{array}{*{20}{c}} {{z_{{\text{r }}}}_{11}}&{{z_{{\text{r }}}}_{12}}& \cdots &{{z_{{\text{r }}}}_{1f}} \\ {{z_{{\text{r }}}}_{21}}&{{z_{{\text{r }}}}_{22}}& \cdots &{{z_{{\text{r }}}}_{2f}} \\ \vdots & \vdots &{}& \vdots \\ {{z_{{\text{r }}}}_{e1}}&{{z_{{\text{r }}}}_{e2}}& \cdots &{{z_{{\text{r }}}}_{ef}} \end{array}} \right] = [\begin{array}{*{20}{c}} {{{\boldsymbol{z}}_{{\text{r }}}}_1}&{{{\boldsymbol{z}}_{{\text{r }}}}_2}& \cdots &{{{\boldsymbol{z}}_{\text{r}}}_f} \end{array}] (11) {{\boldsymbol{Z}}_{\text{g}}} = \left[ {\begin{array}{*{20}{c}} {{z_{{\text{g }}}}_{11}}&{{z_{{\text{g }}}}_{12}}& \cdots &{{z_{{\text{g }}}}_{1f}} \\ {{z_{{\text{g }}}}_{21}}&{{z_{{\text{g }}}}_{22}}& \cdots &{{z_{{\text{g }}}}_{2f}} \\ \vdots & \vdots &{}& \vdots \\ {{z_{{\text{g }}}}_{e1}}&{{z_{{\text{g }}}}_{e2}}& \cdots &{{z_{{\text{g }}}}_{ef}} \end{array}} \right] = [\begin{array}{*{20}{c}} {{{\boldsymbol{z}}_{{\text{g }}}}_1}&{{{\boldsymbol{z}}_{{\text{g }}}}_2}& \cdots &{{{\boldsymbol{z}}_{{\text{g }}}}_f} \end{array}] (12) 接着,计算特征矩阵的多元正态分布均值μr与μg以及协方差矩阵Covr与Covg,如下:

{\boldsymbol{\mu} _{\text{r}}} = \sum\limits_{i = 1}^e {[\begin{array}{*{20}{c}} {\frac{{{z_{\text{r}}}_{i1}}}{e}}&{\frac{{{z_{\text{r}}}_{i2}}}{e}}& \cdots &{\frac{{{z_{\text{r}}}_{if}}}{e}} \end{array}] = [\begin{array}{*{20}{c}} {{\mu _{\text{r}}}_1}&{{\mu _{\text{r}}}_2}& \cdots &{{\mu _{\text{r}}}_f} \end{array}]} (13) {\boldsymbol{\mu} _{\text{g}}} = \sum\limits_{i = 1}^e {(\begin{array}{*{20}{c}} {\frac{{{z_{\text{g}}}_{i1}}}{e}}&{\frac{{{z_{\text{g}}}_{i2}}}{e}}& \cdots &{\frac{{{z_{\text{g}}}_{if}}}{e}} \end{array})} = (\begin{array}{*{20}{c}} {{\mu _{\text{g}}}_1}&{{\mu _{\text{g}}}_2}& \cdots &{{\mu _{\text{g}}}_f} \end{array}) (14) {{\boldsymbol{C}}_{{\text{ov}}}}_{\text{r}} = \left[ {\begin{array}{*{20}{c}} {{c_{{\text{r }}}}_{11}}&{{c_{{\text{r }}}}_{12}}& \cdots &{{c_{{\text{r }}}}_{1f}} \\ {{c_{{\text{r }}}}_{21}}&{{c_{{\text{r }}}}_{21}}& \cdots &{{c_{{\text{r }}}}_{2f}} \\ \vdots & \vdots &{}& \vdots \\ {{c_{{\text{r }}}}_{f1}}&{{c_{{\text{r }}}}_{f2}}& \cdots &{{c_{{\text{r }}}}_{ff}} \end{array}} \right] (15) {{\boldsymbol{C}}_{{\text{ov}}}}_{\text{g}} = \left[ {\begin{array}{*{20}{c}} {{c_{{\text{g }}}}_{11}}&{{c_{{\text{g }}}}_{12}}& \cdots &{{c_{{\text{g }}}}_{1f}} \\ {{c_{{\text{g }}}}_{21}}&{{c_{{\text{g }}}}_{21}}& \cdots &{{c_{{\text{g }}}}_{2f}} \\ \vdots & \vdots &{}& \vdots \\ {{c_{{\text{g }}}}_{f1}}&{{c_{{\text{g }}}}_{f2}}& \cdots &{{c_{{\text{g }}}}_{ff}} \end{array}} \right] (16) 式中Covr与Covg各元素的计算如下:

{c_{{\text{r }}}}_{ij} = \text{E} [{{\boldsymbol{z}}_{\text{r}}}_i - \text{E} ({{\boldsymbol{z}}_{\text{r}}}_i)][{{\boldsymbol{z}}_{\text{r}}}_j - \text{E} ({{\boldsymbol{z}}_{\text{r}}}_j)] (17) {c_{{\text{g }}}}_{ij} = \text{E} [{{\boldsymbol{z}}_{\text{g}}}_i - \text{E} ({{\boldsymbol{z}}_{\text{g}}}_i)][{{\boldsymbol{z}}_{\text{g}}}_j - \text{E} ({{\boldsymbol{z}}_{\text{g}}}_j)] (18) 最后,计算ζFID值,如下所示:

{\zeta _{{\text{FID}}}} = ||{\boldsymbol{\mu} _{\text{r}}} - {\boldsymbol{\mu} _{\text{g}}}|{|^2} + {tr} [{{\boldsymbol{C}}_{{\text{ov}}}}_{\text{r}} + {{\boldsymbol{C}}_{{\text{ov}}}}_{\text{g}} - 2{({{\boldsymbol{C}}_{{\text{ov}}}}_{\text{r}}{{\boldsymbol{C}}_{{\text{ov}}}}_{\text{g}})^{1/2}}] (19) 式中tr(⋅)表示矩阵的迹。

在第1级评估中,Xr取为XFalse和XReal,Xg取为XGenerated,特征提取器采用Inception V3模型。

在第2级评估中,当伪标记图像的伪标记值小于阈值时,认为所生成的燃烧线极端异常火焰图像是符合期望的,即合格。

2. 实验结果及分析

2.1 数据描述

本文研究对象是北京地区某MSWI电厂的一台800 t/d阶梯式(倾斜+水平)顺推机械炉排炉[3],其参数为:全部炉排的水平长度和宽度分别为11003和12 900 mm;分为干燥段、燃烧一段、燃烧二段和燃烬段炉排共4段,长度分别为2 840、2 800、2 840和2 130 mm;其中干燥段炉排的倾斜角度为8°,其他段炉排均为0°。MSW的成分数据与文献[3]一致。

采用同轴电缆对安装在炉膛后壁的工业摄像机所采集的火焰视频进行传输,通过工控机上的视频采集卡和相应软件获取单通道视频后对火焰图像按分钟进行存储。训练CycleGAN的真实火焰图像源于2021年12月份某天的连续561张无标签图像,用于获取伪标记的火焰图像集源于456张燃烧线位置被标定火焰图像。

2.2 实验结果与分析

2.2.1 燃烧线极端异常伪标记火焰图像获取结果

由于焚烧火焰的明亮差异导致曝光程度不同,进而导致图像处理错误的问题,采用的处理方法是:首先,采用不同的超参数对不同时间段的火焰图像集进行形态学处理;然后,人工比对原图像和这些处理图像以确保提取的正确性。该方法虽然具有一定的工作量,但也是可接受的。

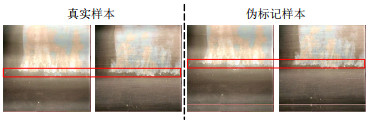

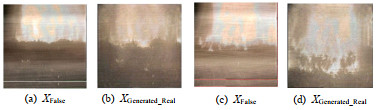

如上文所述,通过对典型燃烧状态图像的像素点平移后获取燃烧线极端异常伪标记火焰图像456张,部分原始和伪标记图像的结果如图 4所示。

在图 4中,红色框框出的为燃烧线。可知:平移后的伪标记图像具有不存在的燃烧线位置信息,同时也存在明显的不合理特征,如火焰亮度、平移痕迹等,故需要将伪标记火焰图像转换成符合真实火焰图像概率分布的生成图像。

2.2.2 候选燃烧线极端异常火焰图像生成结果

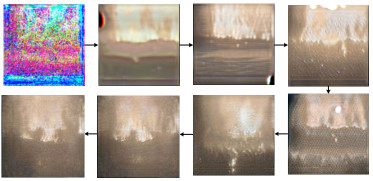

训练过程中的候选燃烧线极端异常火焰图像的变化情况如图 5所示。

图 5中,前5图的批次编号均小于5,后3图是编号为10、60和110批次所生成的火焰图像,结果表明:在批次编号达到10后,生成的图像较为清晰。候选生成结果中存在的部分符合和不符合期望的火焰图像,如图 6所示。

图 6中的图像分别取自XFalse和XGenerated_Real集合,可知:图 6(a)生成效果好;图 6(b)生成效果差,未能保留燃烧线特征。

图 6(a)中,XGenerated_Real能够较好生成的原因在于:1)XGenerated_Real能够保留基于知识进行平移操作而获取的{X_{{\text{False}}}}中的燃烧线位置信息,显然在真实图像集中该信息是缺失的;2)XGenerated_Real符合炉内火焰图像存在的特征与特征间的因果关系,但燃烧线极端异常伪标记火焰图像XFalse却并不满足该关系,如:XGenerated_Real火焰部分的亮度明显低于XFalse;3)在{X_{{\text{False}}}}中,由于平移而存在的不合理特征信息在XGenerated_Real上被消除,如:由于翻转操作遗留的明显横线在XGenerated_Real中已不存在。

图 6(b)中,XGenerated_Real不符合期望,其燃烧线位置特征未能保留的原因在于:初始训练批次时,GFalse_to_ Real的修改能力弱,仅能消除伪标记图像集中明显不合理的特征;GFalse_to_ Real的修改能力随批次的增加而变强,为使得生成图像集分布符合真实图像集的分布,部分伪标记图像被转换成正常或异常的图像,进而导致燃烧线特征未能保留。

2.2.3 图像评估与选取结果

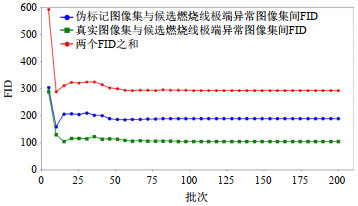

第1级评估通过对各类样本集间相似度的度量,筛选GFalse_to_ Real模型参数,如图 7所示。

由图 7可知:第10批次下生成图像集与伪标记图像集的FID值最小,其相应的模型参数FID值为:伪标记图像集和生成图像集间为158.45,真实图像集与生成图像集间为129.59,两者之和为288.04。

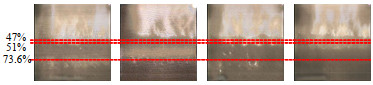

第2级评估是在第1级评估的基础上判断筛选伪标记值以获取最终燃烧线极端异常火焰图像。此处将阈值设定为0.4,对应的生成结果如图 8所示。

结合表 1中的标准在图 8中标出燃烧线的参考线,可知:经过第1级评估所生成的图像是清晰的,训练批次在10~15区间的模型参数相对较优;经过第2级评估能够进一步约束被筛选图像,能够保留燃烧线极端异常特征。

2.3 对比分析

2.3.1 生成算法的对比分析

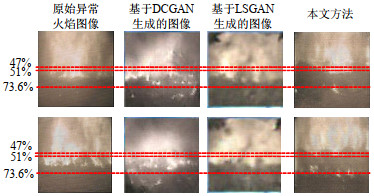

将本文方法与深度卷积生成对抗网络(deep convolution GAN,DCGAN)[12]和最小二乘生成对抗网络(least square GAN,LSGAN)[35]生成的火焰图像进行比较,网络参数、优化算法、学习率的取值等与文献[13]相同,结果如图 9所示。类似图 8,在图 9中也给出参考线,可知:DCGAN和LSGAN能够虽然能够生成火焰图像,但不能获得燃烧线极端异常的图像;本文所提方法能够生成目前在现场采集的真实数据中并不存在的燃烧线极端异常火焰图像,满足构建火焰图像模板库的要求。

2.3.2 评估算法的对比分析及验证

在第1级评估时,加载GFalse_to_ Real不同批次下的模型参数,每个批次均生成456张图像,经人工标记符合期望的图像数量结果如表 3所示。

表 3 不同批次下符合期望的火焰图像数量Table 3. Number of flame images in different epochs批次编号 符合期望的火焰图像数量 5 80 10 135 15 51 20 38 60 10 100 18 表 3表明:批次10的GFalse_to_ Real为最优解;批次5中符合期望的图像也较多,但由图 5可知,其图像质量较差;在批次10后,生成符合期望的图像能力逐渐减弱。该实验结果验证第1级评估的正确性和可靠性,也符合上文的原因分析。

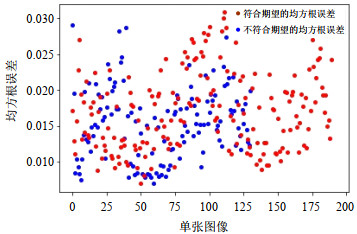

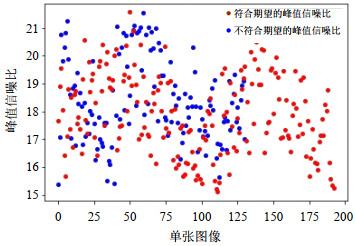

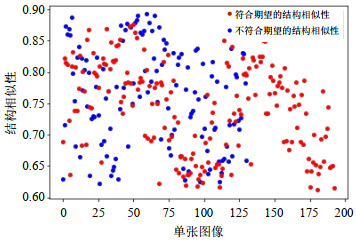

在第2级评估期望图像时,需设定阈值筛选候选样本中符合燃烧线极端异常要求的图像,即找出伪标记图像中能够决定生成图像燃烧线位置的特征。其他通过度量生成图像与伪标记图像间的相似度或特征相似度的指标为:均方根误差(mean square error,MSE)、峰值信噪比(peak signal to noise ratio,PSNR)和结构相似性(structural similarity,SSIM)等[36],MSE用于比较两幅图像的均方差值,相似度与其成负相关;PSNR用于衡量图像噪声水平,相似度与其成正相关;SSIM度量图像间的亮度、对比度和结构,相似度与其成正相关。采用上述方法与本文方法进行对比,实验结果如图 10—12所示。

在图 10—12中,蓝色和红色的点分别表示符合和不符合期望的火焰图像。通常,若评价能够通过设定阈值筛选出符合期望的火焰图像,则在y轴上具有明显的分界面。上述结果表明:MSE、PSNR和SSIM指标均不能够有效筛选出符合期望的样本。

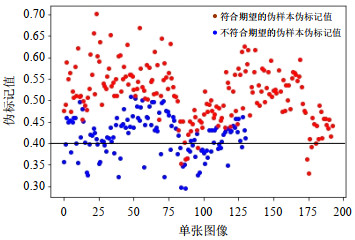

采用本文所提方法在第2级评估中设定阈值,符合与不符合期望的生成样本所对应的伪标记值情况如图 13所示。当阈值设定为0.4时,筛选准确率为85.7%。相比图 10—12,图 13具有较明显的分界面。

3. 结论

本文针对燃烧线极端异常火焰图像缺失问题,融合机理知识和生成对抗网络提出火焰图像生成方法,得到如下结论:

1)通过炉排等比例建模和基于成像原理的燃烧位置标定能够计算得到炉内三维空间到像素点的映射关系,以北京某MSWI厂为例:52.4%~55.7%对应干燥炉排;55.7%~60.9%对应干燥炉排与燃烧炉排台阶;60.9%~73.6%对应燃烧炉排;73.6%~ 84.0%对应燃烧炉排与燃烬炉排台阶;84.0%~100%对应部分燃烬炉排。

2)相较于传统的图像生成和直接平移策略,本文方法优势体现在:生成图像能够保留伪标记图像的燃烧线特征,能够符合炉内火焰图像存在的特征与特征间的因果关系,伪标记图像中因平移而存在的不合理特征信息能够被消除。

3)实验表明:模型生成燃烧线极端异常火焰图像的能力与训练批次数并非正相关,其中:在批次编号小于10时,模型被训练以提升图像生成质量,此时能够生成较多符合燃烧线极端异常要求的图像;在批次编号大于10时,为使得生成图像集的概率分布符合真实图像集的概率分布,更多伪标记燃烧线位置特征被修改,进而导致获取符合期望生成图像的效率降低。因此,如何均衡该关系有待深入探讨。

4)本文所提的三维空间到炉排内的映射关系、图像生成策略直接适用于阶梯式(倾斜+水平)顺推机械炉排炉,对其他尺寸或其他炉型炉排也具有较好的参考作用,能够提供方法支撑。

在未来研究中,将进行基于数据驱动的燃烧线量化检测装置以及基于量化燃烧线的MSWI过程智能控制算法等研究。

-

表 1 三维空间位置到图像像素点的映射关系

Table 1 Mapping relationships from three-dimensional space location to image pixel points

炉膛内实际位置 成像的像

素点范围在图像中的

比例范围/%炉排

长度/mm燃烧线在图像中的

比例范围/%燃烧线状态 炉膛前拱、进料口、进料段与干燥炉排台阶 0~301 0~52.4 — 0~47 极端异常 炉排 干燥炉排 302~320 52.4~55.7 2840 47~51 异常 干燥炉排与燃烧炉排台阶 321~350 55.7~60.9 679.78 51~60.9 正常 燃烧炉排 351~423 60.9~73.6 5680 60.9~73.6 正常 燃烧炉排与燃烬炉排台阶 424~484 73.6~84.0 532.09 73.6~84.0 异常 部分燃烬炉排 484~575 84.0~100 — 84.0~100 异常 表 2 生成和判别网络结构

Table 2 Structure of generation and discrimination network

生成网络 判别网络 下

采

样

模

块x=ZeroPadding2D((3, 3))(input) Conv2D(64, (3, 3)) x=Conv2D(64, (7, 7))(x) LeakyReLU((alpha=0.2)) x=InstanceNormalization()(x) Conv2D(128, (4, 4), strides=1) x=Activation(‘relu’)(x) InstanceNormalization() x=ZeroPadding2D((1, 1))(x) LeakyReLU((alpha=0.2)) x=Conv2D(128, (3, 3))(x) Conv2D(256, (4, 4), strides=1) x=InstanceNormalization()(x) InstanceNormalization() x=Activation(‘relu’)(x) LeakyReLU((alpha=0.2)) x=ZeroPadding2D((1, 1))(x) Conv2D(512, (4, 4), strides=1) x=Conv2D(64, (3, 3))(x) InstanceNormalization() x=InstanceNormalization()(x) LeakyReLU((alpha=0.2)) x=Activation(‘relu’)(x) Conv2D(1, (3, 3), strides=1) 残

差

块X1=ZeroPadding2D((3, 3))(x) x=Conv2D(256, (3, 3))(X1) x=InstanceNormalization()(x) x=Activation(‘relu’)(x) x=ZeroPadding2D((3, 3))(x) x=Conv2D(256, (3, 3))(x) x=InstanceNormalization()(x) x=layers.add([x, X1]) x=Activation(‘relu’)(x) ……(残差块*8) 上

采

样

模

块x=UpSampling((2, 2))(x) x=ZeroPadding2D((1, 1))(x) x=Conv2D(128, (3, 3))(x) x=InstanceNormalization()(x) x=Activation(‘relu’)(x) x=UpSampling2D((2, 2)(x)) x=ZeroPadding2D((1, 1))(x) x=Conv2D(128, (3, 3))(x) x=InstanceNormalization()(x) x=Activation(‘relu’)(x) x=ZeroPadding2D((3, 3))(x) x=Conv2D(3, (7, 7))(x) x=InstanceNormalization()(x) x=Activation(‘tanh’)(x) 表 3 不同批次下符合期望的火焰图像数量

Table 3 Number of flame images in different epochs

批次编号 符合期望的火焰图像数量 5 80 10 135 15 51 20 38 60 10 100 18 -

[1] 乔俊飞, 郭子豪, 汤健. 面向城市固废焚烧过程的二噁英排放浓度检测方法综述[J]. 自动化学报, 2020, 46(6): 1063-1089. https://www.cnki.com.cn/Article/CJFDTOTAL-MOTO202006001.htm QIAO Junfei, GUO Zihao, TANG Jian. Dioxin emission concentration measurement approaches for municipal solid wastes incineration process: a survey[J]. Acta Automatica Sinica, 2020, 46(6): 1063-1089(in Chinese). https://www.cnki.com.cn/Article/CJFDTOTAL-MOTO202006001.htm

[2] 李文瀚, 马增益, 杨恩权, 等. 循环流化床垃圾焚烧系统电除尘飞灰和布袋飞灰特性研究[J]. 中国电机工程学报, 2019, 39(5): 1397-1404. DOI: 10.13334/j.0258-8013.pcsee.181110 LI Wenhan, MA Zengyi, YANG Enquan, et al. Characteristics of electrostatic precipitator ash and bag filter ash from a circulating fluidized bed municipal solid waste incinerator[J]. Proceedings of the CSEE, 2019, 39(5): 1397-1404(in Chinese). DOI: 10.13334/j.0258-8013.pcsee.181110

[3] 庄家宾, 汤健, 夏恒, 等. 炉排固相和炉膛气相燃烧耦合的MSWI过程模拟[J]. 中国电机工程学报, 2022, 42(24): 8961-8971. DOI: 10.13334/j.0258-8013.pcsee.212430 ZHUANG Jiabin, TANG Jian, XIA Heng, et al. MSWI process simulation based on coupling combustion of solid phase on grate and gas phase in furnace[J]. Proceedings of the CSEE, 2022, 42(24): 8961-8971(in Chinese). DOI: 10.13334/j.0258-8013.pcsee.212430

[4] 汤健, 乔俊飞. 基于选择性集成核学习算法的固废焚烧过程二噁英排放浓度软测量[J]. 化工学报, 2019, 70(2): 696-706. https://www.cnki.com.cn/Article/CJFDTOTAL-HGSZ201902033.htm TANG Jian, QIAO Junfei. Dioxin emission concentration soft measuring approach of municipal solid waste incineration based on selective ensemble kernel learning algorithm[J]. CIESC Journal, 2019, 70(2): 696-706(in Chinese). https://www.cnki.com.cn/Article/CJFDTOTAL-HGSZ201902033.htm

[5] 汤健, 王丹丹, 郭子豪, 等. 基于虚拟样本优化选择的城市固废焚烧过程二噁英排放浓度预测[J]. 北京工业大学学报, 2021, 47(5): 431-443. https://www.cnki.com.cn/Article/CJFDTOTAL-BJGD202105003.htm TANG Jian, WANG Dandan, GUO Zihao, et al. Prediction of dioxin emission concentration in the municipal solid waste incineration process based on optimal selection of virtual samples[J]. Journal of Beijing University of Technology, 2021, 47(5): 431-443(in Chinese). https://www.cnki.com.cn/Article/CJFDTOTAL-BJGD202105003.htm

[6] 汤健, 乔俊飞, 徐喆, 等. 基于特征约简与选择性集成算法的城市固废焚烧过程二噁英排放浓度软测量[J]. 控制理论与应用, 2021, 38(1): 110-120. https://www.cnki.com.cn/Article/CJFDTOTAL-KZLY202101012.htm TANG Jian, QIAO Junfei, XU Zhe, et al. Soft measuring approach of dioxin emission concentration in municipal solid waste incineration process based on feature reduction and selective ensemble algorithm[J]. Control Theory & Applications, 2021, 38(1): 110-120(in Chinese). https://www.cnki.com.cn/Article/CJFDTOTAL-KZLY202101012.htm

[7] 吴一全, 朱丽, 周怀春. 基于Krawtchouk矩和支持向量机的火焰状态识别[J]. 中国电机工程学报, 2014, 34(5): 734-740. DOI: 10.13334/j.0258-8013.pcsee.2014.05.004 WU Yiquan, ZHU Li, ZHOU Huaichun. State recognition of flame images based on Krawtchouk moment and support vector machine[J]. Proceedings of the CSEE, 2014, 34(5): 734-740(in Chinese). DOI: 10.13334/j.0258-8013.pcsee.2014.05.004

[8] 丁海旭, 汤健, 夏恒, 等. 基于TS-FNN的城市固废焚烧过程MIMO被控对象建模[J]. 控制理论与应用, 2022, 39(8): 1529-1540. https://www.cnki.com.cn/Article/CJFDTOTAL-KZLY202208020.htm DING Haixu, TANG Jian, XIA Heng, et al. Modeling of MIMO controlled object in municipal solid waste incineration process based on TS-FNN[J]. Control Theory & Applications, 2022, 39(8): 1529-1540(in Chinese). https://www.cnki.com.cn/Article/CJFDTOTAL-KZLY202208020.htm

[9] GARAMI A, CSORDÁS B, PALOTÁS Á, et al. Reaction zone monitoring in biomass combustion[J]. Control Engineering Practice, 2018, 74: 95-106. DOI: 10.1016/j.conengprac.2018.02.009

[10] 张丽霞. 垃圾焚烧机组燃烧状态监测与建模[D]. 北京: 华北电力大学(北京), 2021. ZHANG Lixia. Combustion state monitoring and modeling of municipal solid waste incineration units[D]. Beijing: North China Electric Power University(Beijing), 2021(in Chinese).

[11] 何俊捷, 黄帅, 王亚飞, 等. 基于城市生活垃圾火焰辐射光谱的可燃组分在线预测新方法[J]. 中国电机工程学报, 2020, 40(9): 2959-2966. DOI: 10.13334/j.0258-8013.pcsee.191398 HE Junjie, HUANG Shuai, WANG Yafei, et al. Novel method for on-line predicting of combustible components in municipal solid waste using flame radiation spectrum[J]. Proceedings of the CSEE, 2020, 40(9): 2959-2966(in Chinese). DOI: 10.13334/j.0258-8013.pcsee.191398

[12] 乔俊飞, 段滈杉, 汤健, 等. 基于火焰图像颜色特征的MSWI燃烧工况识别[J]. 控制工程, 2022, 29(7): 1153-1161. https://www.cnki.com.cn/Article/CJFDTOTAL-JZDF202207001.htm QIAO Junfei, DUAN Haoshan, TANG Jian, et al. Recognition of MSWI combustion conditions based on color features of flame images[J]. Control Engineering of China, 2022, 29(7): 1153-1161(in Chinese). https://www.cnki.com.cn/Article/CJFDTOTAL-JZDF202207001.htm

[13] 郭海涛, 汤健, 丁海旭, 等. 基于混合数据增强的MSWI过程燃烧状态识别[J]. 自动化学报, 2024, 50(3): 560-575. https://www.cnki.com.cn/Article/CJFDTOTAL-MOTO202403009.htm GUO Haitao, TANG Jian, DING Haixu, et al. Combustion states recognition method of MSWI process based on mixed data enhancement[J]. Acta Automatica Sinica, 2024, 50(3): 560-575(in Chinese). https://www.cnki.com.cn/Article/CJFDTOTAL-MOTO202403009.htm

[14] 冯晓硕, 沈樾, 王冬琦. 基于图像的数据增强方法发展现状综述[J]. 计算机科学与应用, 2021, 11(2): 370-382. FENG Xiaoshuo, SHEN Yue, WANG Dongqi. A survey on the development of image data augmentation [J]. Computer Science and Application, 2021, 11(2): 370-382(in Chinese).

[15] GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2014: 2672-2680.

[16] 王坤峰, 苟超, 段艳杰, 等. 生成式对抗网络GAN的研究进展与展望[J]. 自动化学报, 2017, 43(3): 321-332. https://www.cnki.com.cn/Article/CJFDTOTAL-MOTO201703001.htm WANG Kunfeng, GOU Chao, DUAN Yanjie, et al. Generative adversarial networks: the state of the art and beyond[J]. Acta Automatica Sinica, 2017, 43(3): 321-332(in Chinese). https://www.cnki.com.cn/Article/CJFDTOTAL-MOTO201703001.htm

[17] 唐贤伦, 杜一铭, 刘雨微, 等. 基于条件深度卷积生成对抗网络的图像识别方法[J]. 自动化学报, 2018, 44(5): 855-864. https://www.cnki.com.cn/Article/CJFDTOTAL-MOTO201805009.htm TANG Xianlun, DU Yiming, LIU Yuwei, et al. Image recognition with conditional deep convolutional generative adversarial networks[J]. Acta Automatica Sinica, 2018, 44(5): 855-864(in Chinese). https://www.cnki.com.cn/Article/CJFDTOTAL-MOTO201805009.htm

[18] YANG Lei, LIU Yanhong, PENG Jinzhu. An automatic detection and identification method of welded joints based on deep neural network[J]. IEEE Access, 2019, 7: 164952-164961. DOI: 10.1109/ACCESS.2019.2953313

[19] LIAN Jian, JIA Weikuan, ZAREAPOOR M, et al. Deep-learning-based small surface defect detection via an exaggerated local variation-based generative adversarial network[J]. IEEE Transactions on Industrial Informatics, 2020, 16(2): 1343-1351. DOI: 10.1109/TII.2019.2945403

[20] NIU Shuanlong, LI Bin, WANG Xinggang, et al. Defect image sample generation with GAN for improving defect recognition[J]. IEEE Transactions on Automation Science and Engineering, 2020, 17(3): 1611-1622.

[21] WU Xiaojun, QIU Lingteng, GU Xiaodong, et al. Deep learning-Based generic automatic surface defect inspection(ASDI) with pixelwise segmentation[J]. IEEE Transactions on Instrumentation and Measurement, 2021, 70: 5004010.

[22] BICHLER M, FICHTL M, HEIDEKRÜGER S, et al. Learning equilibria in symmetric auction games using artificial neural networks[J]. Nature Machine Intelligence, 2021, 3(8): 687-695. DOI: 10.1038/s42256-021-00365-4

[23] MARIANI G, SCHEIDEGGER F, ISTRATE R, et al. BAGAN: data augmentation with balancing GAN[J]. arXiv preprint arXiv: 1803.09655, 2018.

[24] LIN C T, HUANG Shengwei, WU Y Y, et al. GAN-based day-to-night image style transfer for nighttime vehicle detection[J]. IEEE Transactions on Intelligent Transportation Systems, 2021, 22(2): 951-963. DOI: 10.1109/TITS.2019.2961679

[25] ZHANG Chongzhen, TANG Yang, ZHAO Chaoqiang, et al. Multitask GANs for semantic segmentation and depth completion with cycle consistency[J]. IEEE Transactions on Neural Networks and Learning Systems, 2021, 32(12): 5404-5415. DOI: 10.1109/TNNLS.2021.3072883

[26] SHAO Guifang, HUANG Meng, GAO Fengqiang, et al. DuCaGAN: unified dual capsule generative adversarial network for unsupervised image-to-image translation[J]. IEEE Access, 2020, 8: 154691-154707. DOI: 10.1109/ACCESS.2020.3007266

[27] TIAN Sukun, WANG Miaohui, YUAN Fulai, et al. Efficient computer-aided design of dental inlay restoration: a deep adversarial framework[J]. IEEE Transactions on Medical Imaging, 2021, 40(9): 2415-2427. DOI: 10.1109/TMI.2021.3077334

[28] ZHU Junyan, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice, Italy: IEEE, 2017: 2242-2251.

[29] MIYATO T, KATAOKA T, KOYAMA M, et al. Spectral normalization for generative adversarial networks[C]//6th International Conference on Learning Representations. Vancouver: OpenReview. net, 2018.

[30] SHMELKOV K, SCHMID C, ALAHARI K. How good is my GAN?[C]//Proceedings of the 15th European Conference on Computer Vision(ECCV). Munich: Springer, 2018: 218-234.

[31] SALIMANS T, GOODFELLOW I, ZAREMBA W, et al. Improved techniques for training GANs [C]//Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona: Curran Associates Inc., 2016: 2234-2242.

[32] BORJI A. Pros and cons of GAN evaluation measures[J]. Computer Vision and Image Understanding, 2019, 179: 41-65. DOI: 10.1016/j.cviu.2018.10.009

[33] HEUSEL M, RAMSAUER H, UNTERTHINER T, et al. GANs trained by a two time-scale update rule converge to a local Nash equilibrium[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017: 6629-6640.

[34] LUCIC M, KURACH K, MICHALSKI M, et al. Are GANs created equal? A large-scale study[C]//Proceedings of the 32nd International Conference on Neural Information Processing Systems. Montréal: Curran Associates Inc., 2018: 698-707.

[35] MAO Xudong, LI Qing, XIE Haoran, et al. Least squares generative adversarial networks[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice: IEEE, 2017: 2813-2821.

[36] WANG Zhou, BOVIK A C, SHEIKH H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612. DOI: 10.1109/TIP.2003.819861

下载:

下载:

下载:

下载: